原因は誤った経路制御、海外事業者のオペレーションミスか?

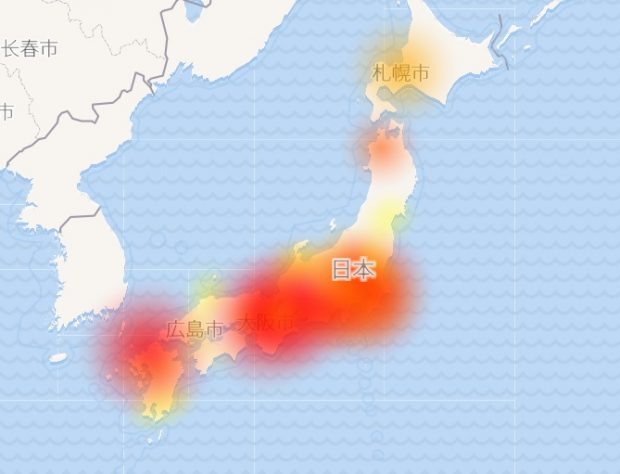

本日昼頃発生した日本全土をほぼ覆う程の通信障害について、原因を特定した模様である。

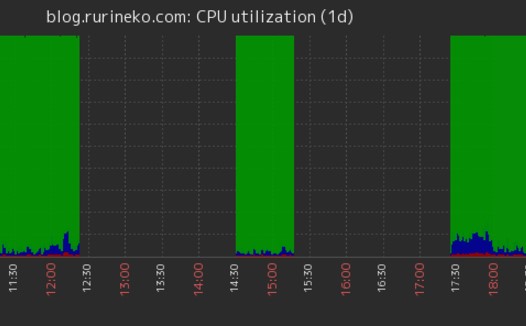

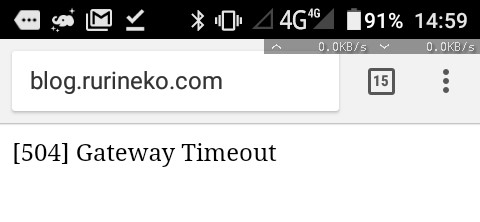

こちらのブログの監視ツールでも検知されていた!

今回の通信障害の原因は、インターネットの通信パケットを正しい宛先(IPアドレス)へ転送するためにネットワーク事業者間で共有している経路制御(BGP:Border Gateway Protocol)の情報に、誤った経路の情報を流してしまったネットワーク事業者がいたことによるものとみられる。これが意図的なのか、オペチョンによる物かは判明はしていないが、これからどこの業者がその情報を流してしまったのか?順次調べを進められる事になるだろう。

BGPについて急上昇ワードがえらい事に!

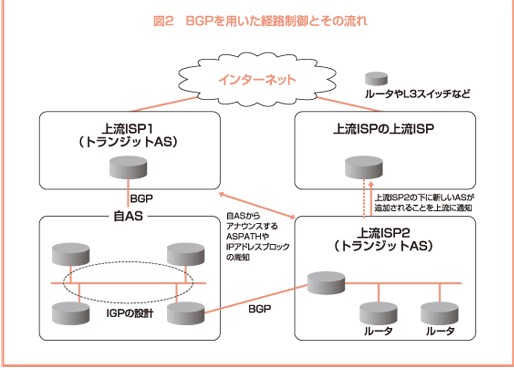

でも、これをみてどれだけの人が理解しただろうか?我々インフラをやっている人間からすると、まあまあ普通の事なのだが、一般人がみてもこれは絶対理解出来ない代物だと思う。ルーティング?プロトコル?なんぞやそれってならないですかね?下記が分かり安いかなと思うけど、結局ルーターやらスイッチが何をどうしているのかを理解出来ないと、読み解けないと思われる。

主原因は、下記じゃないかと言われてる

OCNが相互接続している海外の大手ネットワーク事業者が、OCNのネットワークへ転送すべきIPアドレスに対し、本来は経由すべきではない自社のネットワークへ転送するよう指定してしまった模様だ。そこのパケットの流れを制御しているBGPがOCNのパケットを根こそぎでデータの流れを自社の広域網に流れを変えたことにより、これらの傷害が発生したとのこと。おそらく、そこの通信もOCNからのパケットが大量に押し寄せてパンク状態になり、パケットが衝突しまくり、経路が違う事により正常にパケットが流れなくなり、最後はTCP/IPの理屈でポイされて、パケットが潰れていく感じかなと想像している。

影響を受けたIPアドレスについて

今回の経路障害の影響が及んだIPアドレスは、世界で約10万アドレス。このうち日本国内が約2万5000アドレスだという。ここのブログもなんと、504Gateway Timeoutを返して一時繋がらなくなりました。影響を受けたIPアドレスになりました。なんてこった!どうしようもねーやなぁ。SAKURAもAWSもSlack影響を受けていたとの事なので、軒並み全部駄目だったんでしょう。Slackが繋がらなくなった為、全く仕事が出来なくなったのも事実でw

今後の対策は?

ってこんな事書いても、対策は無しって感じですかね。オペチョンについては、誰でも起こすこともあるし、それをシステム化しても、結局バグってると、結局発生してしまう。という事は、絶対って事は無いので、1%でもその確率を少なくする事が必須かと思われる。